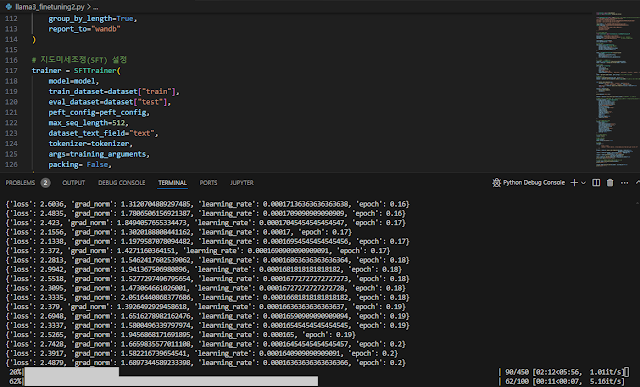

이 글은 LLM 모델 파닝튜닝 도중 만난 삽질을 기록한다. 이 상황은 GPU 24GB 내에서 3B 모델을 파인튜닝하는 과정에서 발생된 문제이다(GPU 거지). 각 모델에 따라 다양한 삽질이 있는 데 대표적인 것만 추려본다.

Google LLM model의 Huggingface google model 403 Client Error 문제 삽질

이 글은 403 Client Error: Forbidden for url: https://huggingface.co/google config.json 삽질을 기록한다.

허깅페이스에서 구글 학습 모델을 다운로드 시도할 때 나오는 메시지인데, 이게 시도하는 상황에 따라 랜덤이라 문제이다.

짜증(내 피 같은 시간을 낭비하다니T.T)

물론 모델 사용은 허가를 받고 진행한 것이다.

- https://huggingface.co/google/gemma-2b/discussions/28

- https://huggingface.co/google/gemma-2b/discussions/11

- https://huggingface.co/google/gemma-7b/discussions/31

- https://huggingface.co/google/gemma-2b-it/discussions/31

- https://huggingface.co/google/gemma-2b/discussions/25

- https://github.com/huggingface/diffusers/issues/6223

구글 모델은 개발자 접근성에 문제가 있어 보인다.

패지키 설치 의존성 에러

작은 리소스에서 Lora를 파인튜닝 어답터로 사용하다 보니 bitandbytes 등 패키지를 기본으로 사용하는 데, 의존성 에러 문제가 발생하였다(최근에는 문제가 많이 해결된 것으로 보임).

결론

세상에 공짜는 없는 듯.. 딥러닝 초창기 우분투, NVIDIA CUDA, 벽돌 PC 반복할 때 생각나네. 아직은 sLLM 개발이 초창기라 발생하는 문제인 듯 보인다.

추신. 그래도, 라마, 파이는 잘 되는 것 같다.

댓글 없음:

댓글 쓰기