이 글은 최근 SLM(Small Language Model) 모델 성능 테스트 사용기를 간략히 정리한 것이다.

테스트를 위해, ollama를 설치한 후, 터미널에서 다음 명령을 입력해 각각 적합한 SLM 모델을 다운로드 받는다.

ollama run gemma2

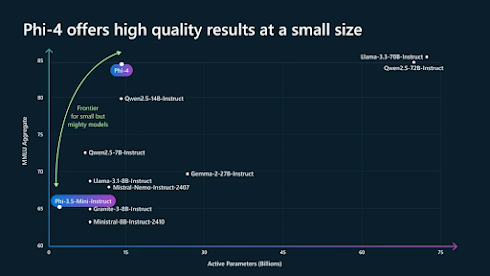

사용한 SLM 모델 중 유명한 gemma-2, llama-3, phi4를 테스트해보았다.

- gemma-2: 실행 속도가 매우 빠르다. 맥락에 따른 정보 생성 성능이 뛰어나다.

- llama-3: 실행 속도는 중간이다. 생성 품질은 뛰어나다.

- phi4: 실행 속도는 중상이다. 생성 품질도 뛰어나다.

- llama-3.2:vision: 멀티모달 기능이 뛰어나다. 다른 것은 보통 수준이다.

다만, 이런 SLM은 4K 이내 프롬프트 크기 입력 등의 한계가 있다.

레퍼런스

- Introducing Phi-3: Redefining what's possible with SLMs | Microsoft Azure Blog

- Complete Guide to Running Ollama’s Large Language Model (LLM) Locally — Part 1 | by Gen. David L. | Medium

- I Ran 9 Popular LLMs on Raspberry Pi 5; Here's What I Found

- How to Install Microsoft Phi-4 Locally?

- What makes Microsoft's Phi-3-Mini AI model worth paying attention to - CO/AI

- Microsoft Phi-4: A Small LLM in Complex Reasoning, Outperforming Qwen 2.5–14B and Performance Overview | by Md Monsur ali | Dec, 2024 | Level Up Coding

- Introducing Phi-4: Microsoft’s Newest Small Language Model Specializing in Complex Reasoning : r/LocalLLaMA

- Gemma2–2B Fine Tuning Complete Guide on Colab | by Yogendra Sisodia | Medium

- Fine-Tuning Gemma 2 and Using it Locally | DataCamp

댓글 없음:

댓글 쓰기