참고로, 현재(2018.2.8) 시점에서는 1.5버전이 릴리즈되어 있다. 1.5버전 설치는 아래 순서는 동일하다. 다만, CUDA 설치 버전을 9.0으로 (9.1 최신버전이 아닌) 설치해야, 텐서플로우 1.5버전과 호환되는 CUDA라이브러리가 설치되는 것만 조심하면 된다.

텐서플로우 1.0 버전은 다음과 같은 성능 개선이 있었다.

- 계산 속도 개선

- tf.layers, tf.metrics, tf.losses 모듈 추가

- 고급 신경망 네트워크 라이브러리인 Keras 라이브러리 호환

- Python API를 NumPy와 유사하게 변경

- 텐서플로우 도메인 컴파일러 XLS 개선

- 텐서플로우 디버거(tfdbg)

- 객체 인식 용 Android 데모 추가

- Pyton 3 도커 이미지 추가

sudo apt-get purge nvidia-*

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt-get update

sudo apt-get install nvidia-375

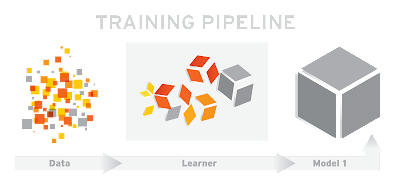

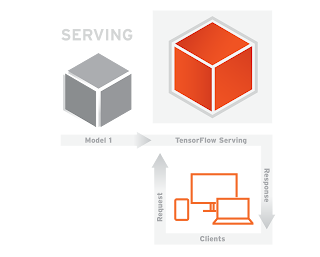

텐서플로우를 이용해 개발된 알고리즘은 텐서보드(tensorboard)를 이용해, 실행 상태를 가시화할 수 있다. 텐서플로 서빙(tensorflow serving)을 이용하면, 텐서플로에서 훈련된 모델을 이용해, 서비스를 운영할 수 있다.

우분투 환경에서는 텐서플로우 설치는 PIP를 이용해 다음처럼 상대적으로 간단하다.

$ sudo apt-get install python-pip python-dev python-virtualenv

$ virtualenv --system-site-packages ~/tensorflow

$ source ~/tensorflow/bin/activate

(tensorflow)$ sudo pip install --upgrade https://storage.googleapis.com/tensorflow/llinux/cpu/tensorflow-0.9.0-cp27-none-linux_x86_64.whl

윈도우 10환경에서는 다음 3가지 방법으로 텐서플로우를 설치할 수 있다.

3. 가상머신(VM, Hyper-V)에서 텐서플로우 설치

아래 링크에서 CUDA 8.0 local 버전을 다운로드 받아 디폴트값으로 설치한다.

아래 링크에서 앞의 CUDA 8.0과 호환되는 CuDNN 버전을 다운로드 받고, 압축파일을 CUDA 폴더 아래에 덮어 써 준다. 참고로, 다운로드 받기 전에 회원가입 절차가 있다.

아래 링크에서 아나콘다 Anaconda3-4.2.0-Windows-x86_64.exe 파일을 다운로드해 설치한다.

텐서플로우를 설치하기 위해, 아나콘다 콘솔 메뉴(Anaconda Prompt)를 실행한다.

IPython은 대화형 파이썬 노트북이다. 파이썬 입력 및 실행 결과를 대화형으로 손쉽게 확인할 수 있다. IPython 을 실행해 다음과 같이 'import tensorflow as tf' 를 입력한다. 아래와 같이 에러가 없다면 성공이다.

9. 파이썬 기타 라이브러리

개발을 위해 필수적인 파이썬 라이브러리를 미리 설치해 놓는 것이 좋다. 아나콘다 콘솔에서 차트, 표, 이미지 처리, 그래픽 가시화와 관련된 아래 패키지를 설치한다.

pip install numpy matplotlib pandas pillow graphviz

다만, scipy 는 윈도우10에서 pip install scipy 시 문제가 있을 수 있다. 이 경우, scipy 설치를 위해서 직접 다운로드하는 방법이 있다. 자세한 내용은 여기(How to get SciPy working in Windows, 2017.2)를 참고한다.

설치 후, 테스트를 위해, 쥬피터 노트북에서 New-Python 메뉴로 노트북을 만들고, 다음 코드를 실행해 본다.

import matplotlib

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(0, 3*np.pi, 500)

plt.plot(x, np.sin(x**2))

plt.title('A simple chirp')

plt.show()

실행 결과가 다음과 같다면 성공한 것이다.

만약, 시간이 좀 더 있다면, 아나콘다 명령창에서 tensorflow와 함께 쓰이는 keras(케라스)도 아래와 같이 설치하여, 공부해 보자.

1. CPU 버전 설치

conda install -c anaconda keras

2. GPU 버전 설치

conda install -c anaconda keras-gpu

케라스 소스와 예제는 다음 링크를 참고한다.

PyTorch(파이토치) 설치 방법은 다음과 같이 매우 간단하다.

conda install pytorch torchvision -c pytorch

배열. concat, slice, split, constant, rank, shape, shuffle

행렬. diag, transpose, matmul, matrix_determinant, matrix_inverse

신경망. softmax, sigmoid, ReLU, Convlution2D, MaxPool

세션. save, restore

큐잉/동기화. enqueue, dequeue, MutexAcquire, MutexRelease

흐름제어. merge, switch, enter, leave, NextIteration

1. 연합 학습의 탄생 배경과 필요성

전통적인 머신러닝은 대량의 데이터를 중앙 서버로 수집하여 모델을 훈련시키는 방식을 기반으로 한다. 그러나 21세기 들어 두 가지 거대한 흐름이 이러한 중앙집중식 접근법의 한계를 드러냈다. 첫째는 데이터 생성의 폭발적인 증가와 분산화이다. 수십억 개의 스마트폰, IoT 기기, 병원, 공장 등 데이터가 발생하는 '엣지(edge)'에서 직접 막대한 양의 데이터가 생성되기 시작했다. 둘째는 데이터 프라이버시에 대한 전 세계적인 인식 강화이다. GDPR(유럽 개인정보보호법), HIPAA(미국 의료정보보호법) 등 강력한 규제는 기업이 사용자의 민감 데이터를 임의로 수집하고 이전하는 것을 엄격히 통제한다.

이 두 흐름의 충돌은 "모델 성능을 높이려면 데이터가 필요하지만, 그 데이터를 중앙으로 합법적이고 효율적으로 옮길 수 없는" 딜레마를 낳았다. 연합 학습은 이 문제를 해결하기 위해 탄생했다. 데이터를 서버로 가져오는 대신, 모델을 데이터가 있는 곳으로 보내 훈련시킨다는 역발상을 통해 데이터 프라이버시를 원천적으로 보호하면서 분산된 데이터의 가치를 활용하는 길을 연 것이다.

연합 학습의 개념을 정립하고 대중화한 주체는 Google이다. 2016년경 Google 연구팀은 안드로이드 스마트폰 사용자의 타이핑 패턴을 학습하여 Gboard 키보드의 단어 추천 기능을 개선하고자 했다. 사용자의 민감한 대화 내용을 서버로 수집하지 않고 이 문제를 해결하기 위한 연구가 연합 학습의 시초가 되었다.

이 아이디어는 2017년 H. Brendan McMahan 등이 발표한 논문 "Communication-Efficient Learning of Deep Networks from Decentralized Data"를 통해 학계에 본격적으로 알려졌고, 이후 연합 학습은 프라이버시 보호 AI의 핵심 기술로 자리 잡았다.

2. 연합 학습의 핵심 동작 원리

연합 학습은 순차적이 아닌, 다수의 클라이언트가 참여하는 병렬적, 반복적 프로세스로 동작한다. 하나의 학습 라운드(Round)는 다음과 같은 단계로 구성된다.

선발 (Selection): 서버는 학습에 참여 가능한 클라이언트 중 일부 그룹을 무작위로 선발한다.

배포 (Distribution): 서버는 현재의 글로벌 모델을 선발된 모든 클라이언트에게 동시에 배포한다.

로컬 학습 (Local Training): 각 클라이언트는 배포받은 모델을 자신의 로컬 데이터로 학습시킨다. 이 과정은 다른 클라이언트와 독립적으로, 병렬적으로 수행된다.

보고 (Reporting): 학습을 마친 클라이언트는 업데이트된 모델 가중치를 서버로 전송한다.

종합 (Aggregation): 서버는 수집된 가중치들을 종합하여 새로운 글로벌 모델을 생성하고, 다음 라운드를 준비한다.

3. Federated Averaging (FedAvg)

서버가 여러 클라이언트의 학습 결과를 종합하는 가장 대표적인 알고리즘은 Federated Averaging (FedAvg)이다. FedAvg의 핵심은 각 클라이언트가 학습에 기여한 데이터의 양에 비례하여 가중치를 부여하는 가중 평균(Weighted Average)을 사용하는 것이다. 데이터가 많은 클라이언트의 학습 결과에 더 높은 영향력을 부여하여, 전체 모델이 더 많은 정보를 반영하도록 유도한다.

4. 기술적 과제와 방어 기법: 신뢰성 확보

4.1. 주요 위협: 모델 포이즈닝

연합 학습 환경은 신뢰할 수 없는 다수의 클라이언트가 참여하므로, 일부 악의적이거나 비정상적인 클라이언트가 오염된 데이터를 학습시켜 전체 모델을 망가뜨리는 모델 포이즈닝(Model Poisoning) 공격에 취약하다. 이는 글로벌 모델의 성능을 저하시키거나 특정 행동을 유도하는 백도어를 삽입하는 형태로 나타날 수 있다.

4.2. 서버 측 방어 기법

이러한 위협을 막기 위해 서버는 수집된 로컬 모델 가중치를 즉시 업데이트하지 않고, 품질을 검증하고 필터링하는 중간 단계를 거친다.

로버스트 집계 (Robust Aggregation): 평균값이 이상치에 민감하다는 단점을 보완하기 위해, 파라미터의 중앙값(Median)이나 상하위 극단값을 제외하고 평균을 내는 절삭 평균(Trimmed Mean) 방식 등을 사용한다.

유사도 기반 필터링 (Similarity-based Filtering): 정상 클라이언트의 모델 업데이트는 벡터 공간에서 서로 유사한 방향성을 가질 것이라는 가정에 기반한다. 서버는 수집된 모든 업데이트 간의 코사인 유사도(Cosine Similarity) 등을 계산하여, 다른 대부분의 업데이트와 동떨어진 방향을 가리키는 이상치를 식별하고 집계 과정에서 제외시킨다.

5. Google의 연합 학습 라이브러리: TensorFlow Federated (TFF)

5.1. TFF의 구조와 특징

TensorFlow Federated (TFF)는 Google이 개발한 연합 학습을 위한 핵심 오픈소스 라이브러리이다. TensorFlow 생태계와 완벽하게 통합되어 Keras 모델 등을 쉽게 활용할 수 있다. TFF는 두 가지 계층의 API를 제공한다.

Federated Learning (FL) API: 고수준 API로, FedAvg와 같은 이미 구현된 알고리즘을 쉽게 가져와 사용할 수 있다. 개발자가 연합 학습을 실제 문제에 빠르게 적용할 수 있도록 돕는다.

Federated Core (FC) API: 저수준 API로, 데이터와 연산의 위치를 직접 제어하며 새로운 분산 알고리즘을 연구하고 개발할 수 있는 유연성을 제공한다.

5.2. TFF 사용 방법: 단계별 예시

다음은 TFF를 사용하여 간단한 MNIST 이미지 분류 연합 학습을 수행하는 과정이다.

import collections

import numpy as np

import tensorflow as tf

import tensorflow_federated as tff

# 1. 연합 데이터셋 준비

# TFF는 실험을 위해 시뮬레이션용 연합 데이터셋을 제공한다.

emnist_train, emnist_test = tff.simulation.datasets.emnist.load_data()

# 클라이언트 1명의 데이터셋 구조 확인

example_dataset = emnist_train.create_tf_dataset_for_client(emnist_train.client_ids[0])

# print(next(iter(example_dataset)))

# 데이터 전처리 함수 정의

def preprocess(dataset):

def batch_format_fn(element):

# 이미지를 1차원으로 펴고, 라벨을 원-핫 인코딩한다.

return collections.OrderedDict(

x=tf.reshape(element['pixels'], [-1, 784]),

y=tf.one_hot(element['label'], 10))

return dataset.repeat(2).shuffle(100).batch(20).map(batch_format_fn)

# 전처리 함수를 적용할 수 있도록 연합 데이터셋을 변환

preprocessed_example_dataset = preprocess(example_dataset)

emnist_train = emnist_train.preprocess(preprocess)

# 2. Keras 모델 정의

# 일반적인 TensorFlow Keras 모델을 정의한다.

def create_keras_model():

return tf.keras.models.Sequential([

tf.keras.layers.Input(shape=(784,)),

tf.keras.layers.Dense(10, kernel_initializer='zeros'),

tf.keras.layers.Softmax(),

])

# 3. 모델을 연합 학습 프로세스로 변환

# TFF가 Keras 모델을 이해하고 연합 학습을 수행할 수 있도록 래핑(wrapping)한다.

def model_fn():

keras_model = create_keras_model()

return tff.learning.from_keras_model(

keras_model,

input_spec=preprocessed_example_dataset.element_spec,

loss=tf.keras.losses.CategoricalCrossentropy(),

metrics=[tf.keras.metrics.CategoricalAccuracy()])

# TFF의 내장된 FedAvg 알고리즘을 빌드한다.

# 이 한 줄의 코드가 서버-클라이언트 간 통신, 로컬 학습, 가중치 종합 등 복잡한 과정을 모두 포함한다.

federated_averaging_process = tff.learning.build_federated_averaging_process(

model_fn,

client_optimizer_fn=lambda: tf.keras.optimizers.SGD(learning_rate=0.02),

server_optimizer_fn=lambda: tf.keras.optimizers.SGD(learning_rate=1.0))

# 4. 연합 학습 훈련 실행

# 서버의 초기 상태를 만든다. (초기 글로벌 모델 가중치 포함)

state = federated_averaging_process.initialize()

# 5 라운드 동안 연합 학습을 실행한다.

NUM_ROUNDS = 5

for round_num in range(1, NUM_ROUNDS + 1):

# 각 라운드마다 훈련에 참여할 클라이언트 일부를 샘플링한다.

sampled_clients_data = [emnist_train.create_tf_dataset_for_client(client_id)

for client_id in np.random.choice(emnist_train.client_ids, size=10, replace=False)]

# 훈련 프로세스의 다음 단계를 실행한다.

# state와 클라이언트 데이터를 입력하면, 업데이트된 state와 라운드별 측정 지표(metrics)가 반환된다.

state, metrics = federated_averaging_process.next(state, sampled_clients_data)

print(f'round {round_num:2d}, metrics={metrics}')

연합 학습은 데이터 프라이버시와 분산화라는 시대적 요구에 부응하는 기술이다. 이는 단순히 분산 환경에서 모델을 훈련하는 것을 넘어, 신뢰할 수 없는 참여자들로부터 전체 시스템을 보호하는 강건한 통계적 검증 및 보안 메커니즘을 포함하는 기술이다. Google의 TensorFlow Federated와 같은 성숙한 오픈소스 프레임워크의 등장은 연합 학습의 도입을 가속화하고 있다. 연합 학습의 성공적인 적용은 효율적인 학습 알고리즘뿐만 아니라, 이처럼 신뢰성을 확보하기 위한 방어 기법의 성숙도에 달려 있다.

9. 윈도우 GPU tensorflow 설치 및 그래픽카드별 성능 비교

10. 병렬처리 – First Contact with TensorFlow

11. Deep Learning을 위해 어떤 GPU를 써야 할까?

12. 윈도우즈에 아나콘다, 텐서플로우 설치하기

13. GPU vs CPU benchmark (Adobe)

14. DIY GPU 서버 : 딥 러닝용 PC 직접 만들기

15. Ubuntu 17.04 Upgrade 및 WSL 잡담

16. 우분투 16.04에서 CUDA 성공적으로 설치하기(무한로긴 현상 발생하는 경우 있음)

17. Ubuntu 16.04 -17.04 NVIDIA drivers install is EASY

18. VI 에디터 사용방법

19. NVIDIA 그래픽 카드 설치 방법(상세)

20. CUDA Toolkit 9.0 Download

21. Tensorflow getting started 1.5

22. cuDNN Download

23. Installing Tensorflow on Ubuntu

24. How to benchmark your GPU on Linux

GPU = GTX 1070 (note book)

1. install NVIDIA driver and CUDA 9.0

refer to No.16

2. if there is login loop, restore NVIDIA driver

sudo apt-get purge nvidia-*

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt-get update

sudo apt-get install nvidia-384

3. install cuDNN for CUDA 9.0

4. install pip and tensorflow

5. install pyton library

6. install keras

상새한 설치가이드 감사합니다! 덕분에 무사히 쉽게 텐서플로우를 설치할 수 있었습니다ㅎ

답글삭제전 가이드를 따라가며 최신 버전으로만 다운로드를 받았는데요. 그럴 경우, cuDNN의 DLL 파일이 *64_6.dll로 받아집니다. 이럴 경우 호환성 문제때문에 import tensorflow에서 에러가 발생하는데, 이를 *64_5.dll로 rename 해주시면 문제가 새결됩니다.

ㅎ 넵. 잘되었네요. 감사합니다~

삭제"DLL load failed: 지정된 모듈을 찾을 수 없습니다."

답글삭제이런 오류가 뜨는데 왜이럴까요? ㅜㅜ

하란대로 다 했는데ㅜㅜ

윈도우버전에서 DLL 에러는 대부분 서로 버전이 안맞아 의존성 문제가 생긴겁니다. 시도해 보시다가 안되시면, docker나 virtualbox, hyper-v 와 같은 VM 에서 텐서플로우가 잘 설치된 이미지를 다운받아 적용해 보십시요.

삭제작성자가 댓글을 삭제했습니다.

답글삭제주피터는 필수적으로 깔아야 되는건가요?

답글삭제텐서플로우 한번도 써본적 없는 초보자인데요

어떤 블로그에서 텐서보드 까는법 찾아봤더니

1. www.python.org 에서 파이썬 깔고

2. anaconda 설치하고

3. anaconda prompt에서

python -m pip install --upgrade pip 치고

conda create -n tensorflow python=3.5 치고

proceed([y]/n)? 뜨면 y 누르고

activate tensorflow 치면

텐서플로우 설치가 되고

4.

마지막으로

https://www.jetbrains.com/pycharm/

여기서 파이참 깔라고 되있는데요

taewook kang님 블로그에서는 주피터라던가 쿠다라던가 설치하라고 되있는데 필수적인건가요?

안녕하세요.

삭제주피터는 설치하셔야, 계산 과정 등을 GUI로 살펴보기 쉽습니다. 콘솔모드에서는 텍스트 기반이라 그래프, 차트, 이미지 등 확인이 쉽지 않습니다.

CUDA 설치하셔야 NVIDIA GPU 이용해 병렬처리로 신경망학습됩니다.

파이참은 파이썬 코드 편집 에디터입니다. 텐서플로우 사용에 큰 관계는 없습니다.

파이썬은 3.5만 깔아야하나요?

답글삭제지금 파이썬 3.7이 다운로드 되어 있으면 'conda create -n tensorflow python=3.5'부분에서 3.5를 3.7로 바꾸면 되는건지 궁금합니다.