이 글은 도커에 대해 간략히 살펴보고, 도커 컨테이너에 우분투, 텐서플로우, PyTorch(파이 토치)를 설치해 본다.

- Install Docker

- Windows 10에서 Docker for Windows 설치

- Docker Windows에 설치하기

- 도커 안내서 및 명령어

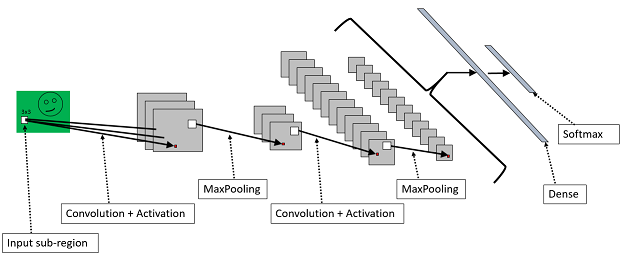

- PyTorch Tutorial (CNN)

1. 개념

도커는 2013년 3월 Pycon 컨퍼런스(산타클라라)에서 dotCloud 창업자인 Solomon Hykes가 리눅스 컨테이너의 미래라는 세션을 발표하면서 처음 알려졌다. 이후 도커는 급성장해 2015년 4월 1,100억원 투자유치를 받았으며, 마이크로소프트가 2016년 6월 4 billion dollar에 도커를 인수하려 했다.

도커는 컨테이너 기반 오픈소스 가상화 플랫폼이다. 실행 중인 컨테이너에 접속해 명령을 실행하고, apt-get 으로 패키지를 설치할 수 있다. 여러 프로세스를 백그라운드로 실행할 수 있다.

이미지는 컨테이너 실행에 필요한 파일과 설정값을 포함하고 있다. 컨테이너는 이미지를 실행한 상태이다. 예를 들어, 우분투 이미지는 우분투 실행을 위한 모든 파일을 가지고 있다.

이미지는 컨테이너 실행에 필요한 파일과 설정값을 포함하고 있다. 컨테이너는 이미지를 실행한 상태이다. 예를 들어, 우분투 이미지는 우분투 실행을 위한 모든 파일을 가지고 있다.

도커는 레이어 구조로 설치 패키지를 관리하기 때문에, 이미 빌드된 레이어를 재활용해, 도커 빌드 속도를 크게 개선할 수 있다. 아울러, 빌드된 레이어를 재활용해, 빌드될 이미지를 조합할 수 있다.

도커 이미지는 Docker hub에 등록되거나 Docker Registry 저장소를 만들어 관리할 수 있다. 현재 공개된 도커 이미지는 50만개 이상이며, 도커 기반 오픈소스 프로젝트는 10만개가 넘는다.

이미지는 url 방식으로 관리하고, 태그를 붙일 수 있다. 도커는 이미지를 만들기 위해 Dockerfile 이란 DSL(domain specific language)를 이용해 이미지 생성과정을 기술한다.

도커 명령어는 직관적이며, http기반의 REST API도 지원해 확장성이 좋다.

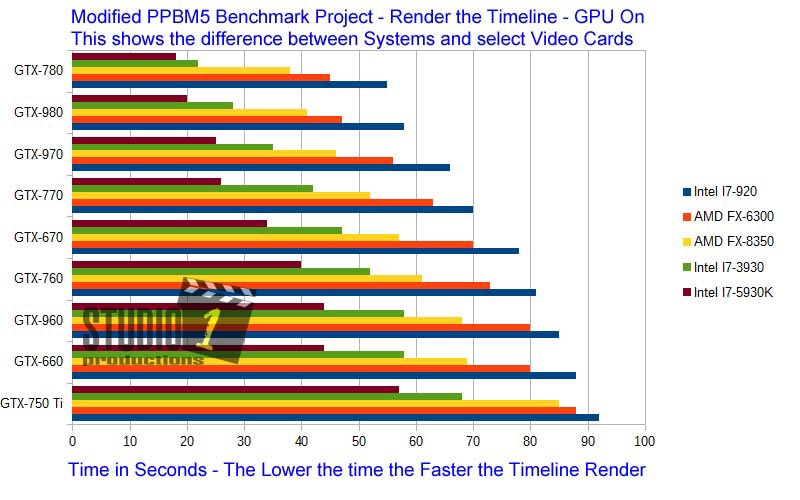

도커는 가상머신에 비해 사용이 쉽고 성능이 좋으나 한계가 있다. 운영체제의 라이브러리 및 시스템을 재활용하므로, 이에 의존되어 동작된다. 만약, 운영체제의 드라이버 설정에 GPU가 설치안되어 있다면, 도커 이미지도 이와 관련된 라이브러리를 사용하지 못할 것이다. 이는 성능은 느리나 운영체제 독립적인 가상머신과는 크게 다른 점이다.

도커를 설치하는 방법은 간단하다. 아래 링크를 클릭해 적당한 버전을 설치하면 된다. 맥, 윈도우, 리눅스 버전 등이 제공된다.

도커는 가상머신에 비해 사용이 쉽고 성능이 좋으나 한계가 있다. 운영체제의 라이브러리 및 시스템을 재활용하므로, 이에 의존되어 동작된다. 만약, 운영체제의 드라이버 설정에 GPU가 설치안되어 있다면, 도커 이미지도 이와 관련된 라이브러리를 사용하지 못할 것이다. 이는 성능은 느리나 운영체제 독립적인 가상머신과는 크게 다른 점이다.

2. 도커 설치

만약, 윈도우 10 버전에서 하이퍼-V(Hyper-V) 가상머신을 사용해 도커를 실행하려면, 윈도우 10 프로페셔널 이상 운영체제가 설치되어야 함에 주의한다. 하위 버전에서는 오라클 VirtualBox가 설치된다(성능이 하이퍼-V보다 낮다고 알려져 있다).

설치 후에 Docker Quickstart Terminal, Kitematic, Oracle VM VirtualBox(혹은 Hyper-V)가 설치된 것을 확인할 수 있다.

참고 - 2019년 4월 도커 버전과 Kitematic 버전이 서로 문제를 일으켜서, 도커 이미지 다운로드 안되는 현상있음. 이 경우, https://github.com/docker/kitematic/releases 에서 Kitematic 0.17.3 버전을 다운로드 받아 실행해 볼것.

참고 - 2019년 4월 도커 버전과 Kitematic 버전이 서로 문제를 일으켜서, 도커 이미지 다운로드 안되는 현상있음. 이 경우, https://github.com/docker/kitematic/releases 에서 Kitematic 0.17.3 버전을 다운로드 받아 실행해 볼것.

3. 실행

도커 버전을 확인하기 위해, Docker Quickstart Terminal을 실행해 다음과 같은 명령을 내려 본다.

$ docker version

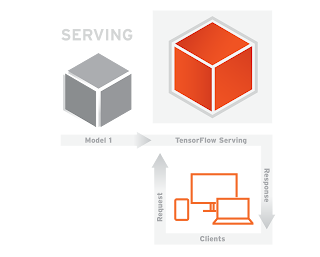

도커는 서버와 클라이언트로 분리되어 있고, 명령을 입력하면, 클라이언트가 서버로 명령을 전송하고 결과를 받아 터미널에 출력해 준다.

도커 클라이언트 서버 구조

Kitematic 를 실행해 보면, 도커 가상머신에서 올릴 수 있는 수많은 이미지를 검색할 수 있다(2019년 4월 현재 도커 최신 버전과 Kitematic 버전이 서로 문제를 일으켜서, 다운로드가 안됨. 이 경우, https://github.com/docker/kitematic/releases 에서 Kitematic 0.17.3 버전을 다운로드 받아 실행해 볼것). 검색한 이미지는 도커 위에서 생성해 사용할 수 있다.

4. 우분투 이미지 생성 및 실행하기

우분투 이미지를 올려보자. 터미널을 실행하고, 아래 명령을 실행해 본다.

$ docker run ubuntu:16.04

만약, 이미지가 로컬에 없다면, 다운로드(pull 명령) 후 컨테이너를 생성(create 명령)하고, 시작(start)한다. 우분투 이미지에 명령은 전달하지 않았기 때문에 이미지는 시작하자 마자 종료된다.

이제, /bin/bash 명령어를 이용해, 컨테이너를 실행한다.

$ docker run --rm -it ubuntu:16.04 /bin/bash

도커의 각 명령은 docker 명령해 뒤에 아래 명령을 추가하면 실행된다. 각 명령의 의미는 다음과 같다.

| 옵션 | 설명 |

|---|---|

| -d | detached mode 흔히 말하는 백그라운드 모드 |

| -p | 호스트와 컨테이너의 포트를 연결 (포워딩) |

| -v | 호스트와 컨테이너의 디렉토리를 연결 (마운트) |

| -e | 컨테이너 내에서 사용할 환경변수 설정 |

| –name | 컨테이너 이름 설정 |

| –rm | 프로세스 종료시 컨테이너 자동 제거 |

| -it | -i와 -t를 동시에 사용한 것으로 터미널 입력을 위한 옵션 |

| –link | 컨테이너 연결 [컨테이너명:별칭] |

exit 를 실행해 bash 쉘을 종료하면, 우분투 이미지 컨테이너도 자동 종료된다.

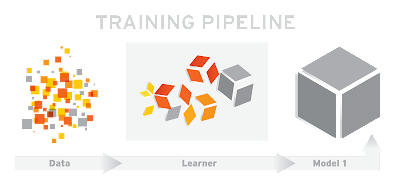

5. 텐서플로우 이미지 실행

이제 구글의 머신러닝 플랫폼인 텐서플로우 이미지를 실행해 보자. 다음 명령어를 도커 입력하면, 이미지를 다운로드 받은 후 실행된다.

$ docker run -d -p 8888:8888 -p 6006:6006 teamlab/pydata-tensorflow:0.1

이미지가 실행된 후, 웹브라우저에서 jupyter를 접속해, 파이썬 코드를 입력해 본다. 제대로 실행되면, 성공한 것이다.

6. PyTorch 이미지 실행

PyTorch는 텐서플로우와 비슷한 머신러닝 플랫폼이다.

다음 명령을 입력해, PyTorch 이미지를 컨테이너에서 실행해 본다. 참고로 이미지는 DockerHub의 StepanKuzmin의 pytorch-notebook을 사용한다.

$ docker run -it --rm -p 8888:8888 stepankuzmin/pytorch-notebook

이 장은 도커 이미지 개념을 이해하기 쉽도록, 간단하게 도커 우분투, node.js 서버 이미지 만드는 방법을 설명한다. 도커가 설치되었다는 가정하에 다음 명령을 입력한다(우분투 기준). 참고로, NVIDIA GPU 도커 이미지는 현재 우분투에서 밖에 지원되지 않는다.

mkdir -p nginx-image

cd nginx-image/

touch Dockerfile

gedit Dockerfile

다음과 같이 우분투 20.04 버전을 기반으로 NGNIX 서버를 설치하고, 환경을 설정하는 명령을 Dockerfile에 입력한 후 저장한다.

# Download base image ubuntu 20.04

FROM ubuntu:20.04

# LABEL about the custom image

LABEL maintainer="admin@sysadminjournal.com"

LABEL version="0.1"

LABEL description="This is custom Docker Image for \

the PHP-FPM and Nginx Services."

# Disable Prompt During Packages Installation

ARG DEBIAN_FRONTEND=noninteractive

# Update Ubuntu Software repository

RUN apt update

# Install nginx, php-fpm and supervisord from ubuntu repository

RUN apt install -y nginx php-fpm supervisor && \

rm -rf /var/lib/apt/lists/* && \

apt clean

# Define the ENV variable

ENV nginx_vhost /etc/nginx/sites-available/default

ENV php_conf /etc/php/7.4/fpm/php.ini

ENV nginx_conf /etc/nginx/nginx.conf

ENV supervisor_conf /etc/supervisor/supervisord.conf

# Enable PHP-fpm on nginx virtualhost configuration

COPY default ${nginx_vhost}

RUN sed -i -e 's/;cgi.fix_pathinfo=1/cgi.fix_pathinfo=0/g' ${php_conf} && \

echo "\ndaemon off;" >> ${nginx_conf}

# Copy supervisor configuration

COPY supervisord.conf ${supervisor_conf}

RUN mkdir -p /run/php && \

chown -R www-data:www-data /var/www/html && \

chown -R www-data:www-data /run/php

# Volume configuration

VOLUME ["/etc/nginx/sites-enabled", "/etc/nginx/certs", "/etc/nginx/conf.d", "/var/log/nginx", "/var/www/html"]

# Copy start.sh script and define default command for the container

COPY start.sh /start.sh

CMD ["./start.sh"]

# Expose Port for the Application

EXPOSE 80 443

file=/dev/shm/supervisor.sock ; (the path to the socket file)

[supervisord]

logfile=/var/log/supervisord.log ; (main log file;default $CWD/supervisord.log)

logfile_maxbytes=50MB ; (max main logfile bytes b4 rotation;default 50MB)

logfile_backups=10 ; (num of main logfile rotation backups;default 10)

loglevel=info ; (log level;default info; others: debug,warn,trace)

pidfile=/tmp/supervisord.pid ; (supervisord pidfile;default supervisord.pid)

nodaemon=false ; (start in foreground if true;default false)

minfds=1024 ; (min. avail startup file descriptors;default 1024)

minprocs=200 ; (min. avail process descriptors;default 200)

user=root ;

[rpcinterface:supervisor]

supervisor.rpcinterface_factory = supervisor.rpcinterface:make_main_rpcinterface

[supervisorctl]

serverurl=unix:///dev/shm/supervisor.sock ; use a unix:// URL for a unix socket

[include]

files = /etc/supervisor/conf.d/*.conf

[program:php-fpm7.4]

command=/usr/sbin/php-fpm7.4 -F

numprocs=1

autostart=true

autorestart=true

[program:nginx]

command=/usr/sbin/nginx

numprocs=1

autostart=true

autorestart=true

다음과 같이 start.sh 파일을 생성한다.

#!/bin/sh

/usr/bin/supervisord -n -c /etc/supervisor/supervisord.conf

다음과 같이 실행권한으로 변경한다.

chmod +x start.sh

빌드 후 이미지 리스트를 확인한다.

docker image ls

도커 이미지 실행 후 데이터베이스같은 파일을 저장하고, 종료하면, 파일도 함께 사라진다. 하지만, 도커 마운트를 이용하면, 도커를 실행하는 호스트 파일 시스템에 도커에서 생성된 파일들을 영구 보관할 수 있다.

도커는 이를 위해 볼륨(volume), 바인드 마운트(bind mount) 두 가지 방법을 제공한다.

볼륨은 다음과 같은 명령으로 생성한다. 이를 통해 다중 도커 이미지 간 폴더 파일들을 함께 공유할 수 있다.

docker volume create

예를 들어 다음과 같이 볼륨을 생성하고, 도커를 실행하면, myvol이 도커 /app와 연결된다.

docker volume create my-vol

docker run -d --name devtest --mount source=myvol, target=/app nginx:latest

볼륨 저장 위치는 다음 명령으로 알 수 있다.

docker inspect my-vol

바인드 마운트는 호스트 파일 시스템의 중요 시스템 변경이 가능하다. 바인드를 위해서, 다음 $(pwd)부분을 현재 바인드할 폴더명령 입력한다. 다음 예는 ngnix 서버를 실행하며, 영구 저장할 파일이 보관될 곳으로 $(pwd)와 /app를 서로 바인딩하는 예이다.

docker run -d -it --name devtest --mount type=bind, source="$(pwd)"/target, target=/app nginx:latest

이를 통해, 도커 이미지를 종료하더라도 이미지에서 생성, 수정한 파일을 영구 보관할 수 있다. 다음 링크는 mysql database file을 마운트를 통해 영구 보관하는 방법을 보여준다.

지금까지 도커 개발 방법을 간단히 살펴보았다. 도커는 운영체계 라이브러리에 의존하므로, 윈도우에서는 아직 NVIDIA GPU 도커가 동작하지 않는다. 즉, GPU 모드 딥러닝 프레임웍을 사용할 수가 없다. 여기서는 NVIDIA GPU 우분투 도커 버전을 간략히 설명한다.

이 도커는 아래 구조로 동작한다.

NVIDIA GPU 도커 이미지는 우분투 16.04, 18.04, 20.04에서 동작한다.

다음 명령을 통해 NVIDIA GPU 도커를 설치한다.

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker

# Add the package repositories

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

zypper ar https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.repo

sudo zypper install -y nvidia-docker2 # accept the overwrite of /etc/docker/daemon.json

sudo systemctl restart docker

다음과 같이 사용한다.

#### Test nvidia-smi with the latest official CUDA image

docker run --gpus all nvidia/cuda:10.0-base nvidia-smi

# Start a GPU enabled container on two GPUs

docker run --gpus 2 nvidia/cuda:10.0-base nvidia-smi

# Starting a GPU enabled container on specific GPUs

docker run --gpus '"device=1,2"' nvidia/cuda:10.0-base nvidia-smi

docker run --gpus '"device=UUID-ABCDEF,1"' nvidia/cuda:10.0-base nvidia-smi

# Specifying a capability (graphics, compute, ...) for my container

# Note this is rarely if ever used this way

docker run --gpus all,capabilities=utility nvidia/cuda:10.0-base nvidia-smi

이 장에서는 도커 명령을 간단히 요약해 본다.

1. 컨테이너 목록 확인하기

$ docker ps -a

2. 컨테이너 중지하기

$ docker stop ${container ID}

3. 컨테이너 제거하기

$ docker rm ${container ID#1} ${container ID#2}

4. 이미지 목록 확인하기

$ docker images

5. 이미지 다운로드 하기

$ docker pull

6. 이미지 삭제하기

$ docker rmi ${image ID}

7. 컨테이너 로그 보기

$ docker logs --tail 10 ${container ID}

8. 실시간 컨테이너 로그 보기

$ docker logs -f ${container ID}

9. 실행중인 컨테이너에 명령 실행하기

$ docker exec [option] container command [arg ...]

run은 새로 컨테이너를 만들어 실행하고, exec는 실행 중인 컨테이너에 명령을 실행하는 차이이다.

다음은 MySQL 컨테이너의 /bin/bash 쉘을 실행하는 예이다.

$ docker exec -it mysql /bin/bash

10. 도커 컨테이너 업데이트

도커에서 컨테이너를 업데이트할 때 컨테이너에 생성된 파일은 모두 삭제될 수 있다. 그러므로, 유지해야 할 데이터가 있는 경우, 컨테이너 내부가 아닌 외부 스토리지에 저장해야 한다.

11. 도커 컴포즈

도커 컴포즈 툴을 이용해, 도커 명령을 하나의 설정으로 간편하게 처리할 수 있다. 자세한 내용은 다음 링크를 참고한다.

기타 도커에서 생성된 데이터를 보관하려면 호스트 드라이버와 연결해 데이터를 저장하거나, 도커 볼륨을 생성해 그 위에 도커를 생성해 사용해야 한다. 그냥 도커를 실행한 후 종료하면 그 동안 작업된 데이터는 삭제된다는 것을 주의해야 한다. 관련 내용은 아래를 참고한다.

6. PyTorch 이미지 실행

PyTorch는 텐서플로우와 비슷한 머신러닝 플랫폼이다.

$ docker run -it --rm -p 8888:8888 stepankuzmin/pytorch-notebook

7. 간단한 도커 우분투, Ngnix 서버 이미지 만들기

mkdir -p nginx-image

cd nginx-image/

touch Dockerfile

gedit Dockerfile

다음과 같이 우분투 20.04 버전을 기반으로 NGNIX 서버를 설치하고, 환경을 설정하는 명령을 Dockerfile에 입력한 후 저장한다.

# Download base image ubuntu 20.04

FROM ubuntu:20.04

# LABEL about the custom image

LABEL maintainer="admin@sysadminjournal.com"

LABEL version="0.1"

LABEL description="This is custom Docker Image for \

the PHP-FPM and Nginx Services."

# Disable Prompt During Packages Installation

ARG DEBIAN_FRONTEND=noninteractive

# Update Ubuntu Software repository

RUN apt update

# Install nginx, php-fpm and supervisord from ubuntu repository

RUN apt install -y nginx php-fpm supervisor && \

rm -rf /var/lib/apt/lists/* && \

apt clean

# Define the ENV variable

ENV nginx_vhost /etc/nginx/sites-available/default

ENV php_conf /etc/php/7.4/fpm/php.ini

ENV nginx_conf /etc/nginx/nginx.conf

ENV supervisor_conf /etc/supervisor/supervisord.conf

# Enable PHP-fpm on nginx virtualhost configuration

COPY default ${nginx_vhost}

RUN sed -i -e 's/;cgi.fix_pathinfo=1/cgi.fix_pathinfo=0/g' ${php_conf} && \

echo "\ndaemon off;" >> ${nginx_conf}

# Copy supervisor configuration

COPY supervisord.conf ${supervisor_conf}

RUN mkdir -p /run/php && \

chown -R www-data:www-data /var/www/html && \

chown -R www-data:www-data /run/php

# Volume configuration

VOLUME ["/etc/nginx/sites-enabled", "/etc/nginx/certs", "/etc/nginx/conf.d", "/var/log/nginx", "/var/www/html"]

# Copy start.sh script and define default command for the container

COPY start.sh /start.sh

CMD ["./start.sh"]

# Expose Port for the Application

EXPOSE 80 443

이제 앞서 추가 설정해야 할 Nginx 웹서버 설정 파일을 다음과 같이 수정한다.

gedit default

server {

listen 80 default_server;

root /var/www/html;

index index.html index.htm index.nginx-debian.html;

server_name _;

location / {

try_files $uri $uri/ =404;

}

location ~ \.php$ {

include snippets/fastcgi-php.conf;

fastcgi_pass unix:/run/php/php7.4-fpm.sock;

}

}

다음과 같이 supervisrod.conf 파일을 생성한다.

[unix_http_server]file=/dev/shm/supervisor.sock ; (the path to the socket file)

[supervisord]

logfile=/var/log/supervisord.log ; (main log file;default $CWD/supervisord.log)

logfile_maxbytes=50MB ; (max main logfile bytes b4 rotation;default 50MB)

logfile_backups=10 ; (num of main logfile rotation backups;default 10)

loglevel=info ; (log level;default info; others: debug,warn,trace)

pidfile=/tmp/supervisord.pid ; (supervisord pidfile;default supervisord.pid)

nodaemon=false ; (start in foreground if true;default false)

minfds=1024 ; (min. avail startup file descriptors;default 1024)

minprocs=200 ; (min. avail process descriptors;default 200)

user=root ;

[rpcinterface:supervisor]

supervisor.rpcinterface_factory = supervisor.rpcinterface:make_main_rpcinterface

[supervisorctl]

serverurl=unix:///dev/shm/supervisor.sock ; use a unix:// URL for a unix socket

[include]

files = /etc/supervisor/conf.d/*.conf

[program:php-fpm7.4]

command=/usr/sbin/php-fpm7.4 -F

numprocs=1

autostart=true

autorestart=true

[program:nginx]

command=/usr/sbin/nginx

numprocs=1

autostart=true

autorestart=true

다음과 같이 start.sh 파일을 생성한다.

#!/bin/sh

/usr/bin/supervisord -n -c /etc/supervisor/supervisord.conf

다음과 같이 실행권한으로 변경한다.

chmod +x start.sh

다음 명령을 실행해 앞서 생성한 도커 파일들 의존성을 확인한다.

tree .

다음과 같이 도커를 빌드한다.

docker build -t nginx-image .

docker image ls

다음과 같이 index.html 파일을 생성한다.

echo '<h1>Nginx and PHP-FPM 7.4 inside Docker Container with Ubuntu 20.04 Base Image</h1>' > /webroot/index.html

웹 루트 폴더를 생성한다. 그리고, 다음과 같이 도커 이미지를 통해 웹서버를 실행한다.

mkdir -p /webroot

docker run -d -v /webroot:/var/www/html -p 8080:80 --name test-container nginx-image

크롬으로 로컬호스트 8080 포트를 입력하면, 설정된 도커 nginx 서버가 실행될 것이다.

도커 이미지 내부 파일 저장하기

도커는 이를 위해 볼륨(volume), 바인드 마운트(bind mount) 두 가지 방법을 제공한다.

볼륨은 다음과 같은 명령으로 생성한다. 이를 통해 다중 도커 이미지 간 폴더 파일들을 함께 공유할 수 있다.

docker volume create

예를 들어 다음과 같이 볼륨을 생성하고, 도커를 실행하면, myvol이 도커 /app와 연결된다.

docker volume create my-vol

docker run -d --name devtest --mount source=myvol, target=/app nginx:latest

볼륨 저장 위치는 다음 명령으로 알 수 있다.

docker inspect my-vol

바인드 마운트는 호스트 파일 시스템의 중요 시스템 변경이 가능하다. 바인드를 위해서, 다음 $(pwd)부분을 현재 바인드할 폴더명령 입력한다. 다음 예는 ngnix 서버를 실행하며, 영구 저장할 파일이 보관될 곳으로 $(pwd)와 /app를 서로 바인딩하는 예이다.

docker run -d -it --name devtest --mount type=bind, source="$(pwd)"/target, target=/app nginx:latest

이를 통해, 도커 이미지를 종료하더라도 이미지에서 생성, 수정한 파일을 영구 보관할 수 있다. 다음 링크는 mysql database file을 마운트를 통해 영구 보관하는 방법을 보여준다.

NVIDIA GPU 도커 사용하기

지금까지 도커 개발 방법을 간단히 살펴보았다. 도커는 운영체계 라이브러리에 의존하므로, 윈도우에서는 아직 NVIDIA GPU 도커가 동작하지 않는다. 즉, GPU 모드 딥러닝 프레임웍을 사용할 수가 없다. 여기서는 NVIDIA GPU 우분투 도커 버전을 간략히 설명한다.

이 도커는 아래 구조로 동작한다.

NVIDIA GPU 도커 이미지는 우분투 16.04, 18.04, 20.04에서 동작한다.

다음 명령을 통해 NVIDIA GPU 도커를 설치한다.

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker

# Add the package repositories

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

zypper ar https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.repo

sudo zypper install -y nvidia-docker2 # accept the overwrite of /etc/docker/daemon.json

sudo systemctl restart docker

다음과 같이 사용한다.

#### Test nvidia-smi with the latest official CUDA image

docker run --gpus all nvidia/cuda:10.0-base nvidia-smi

# Start a GPU enabled container on two GPUs

docker run --gpus 2 nvidia/cuda:10.0-base nvidia-smi

# Starting a GPU enabled container on specific GPUs

docker run --gpus '"device=1,2"' nvidia/cuda:10.0-base nvidia-smi

docker run --gpus '"device=UUID-ABCDEF,1"' nvidia/cuda:10.0-base nvidia-smi

# Specifying a capability (graphics, compute, ...) for my container

# Note this is rarely if ever used this way

docker run --gpus all,capabilities=utility nvidia/cuda:10.0-base nvidia-smi

도커 명령어

1. 컨테이너 목록 확인하기

$ docker ps -a

2. 컨테이너 중지하기

$ docker stop ${container ID}

3. 컨테이너 제거하기

$ docker rm ${container ID#1} ${container ID#2}

4. 이미지 목록 확인하기

$ docker images

5. 이미지 다운로드 하기

$ docker pull

6. 이미지 삭제하기

$ docker rmi ${image ID}

7. 컨테이너 로그 보기

$ docker logs --tail 10 ${container ID}

8. 실시간 컨테이너 로그 보기

$ docker logs -f ${container ID}

9. 실행중인 컨테이너에 명령 실행하기

$ docker exec [option] container command [arg ...]

run은 새로 컨테이너를 만들어 실행하고, exec는 실행 중인 컨테이너에 명령을 실행하는 차이이다.

다음은 MySQL 컨테이너의 /bin/bash 쉘을 실행하는 예이다.

$ docker exec -it mysql /bin/bash

10. 도커 컨테이너 업데이트

도커에서 컨테이너를 업데이트할 때 컨테이너에 생성된 파일은 모두 삭제될 수 있다. 그러므로, 유지해야 할 데이터가 있는 경우, 컨테이너 내부가 아닌 외부 스토리지에 저장해야 한다.

11. 도커 컴포즈

도커 컴포즈 툴을 이용해, 도커 명령을 하나의 설정으로 간편하게 처리할 수 있다. 자세한 내용은 다음 링크를 참고한다.

기타 도커에서 생성된 데이터를 보관하려면 호스트 드라이버와 연결해 데이터를 저장하거나, 도커 볼륨을 생성해 그 위에 도커를 생성해 사용해야 한다. 그냥 도커를 실행한 후 종료하면 그 동안 작업된 데이터는 삭제된다는 것을 주의해야 한다. 관련 내용은 아래를 참고한다.

도커 이미지 완전 삭제 방법

도커 이미지를 완전히 삭제하기 위해서는 이미지를 사용하는 컨테이너를 모두 제거한 후 삭제해야 한다. 아래와 같이 명령을 실행한다. 지금 실행된 이미지들을 리스트한 후, 해당 이미지를 삭제해보자. 명령어에 있는 숫자들은 삭제할 IMAGE ID 이다.

sudo docker images

sudo docker rm -f $(sudo docker ps -a --filter ancestor=8b9d78381e5d)

sudo docker stop $(sudo docker ps -a --filter ancestor=8b9d78381e5d)

sudo docker rmi 8b9d78381e5d

이래도 안되면, 다음 명령을 입력하면 완전 삭제될 것이다.

docker system prune --all --volumes --force && docker volume prune --all --force

마무리

간단히 도커를 이용해, 우분투와 텐서플로우드를 설치해 보고, 실행해 보았다. 도커는 매우 가벼운 가상머신 컨테이너를 제공하고, 다양한 이미지들을 제공해 사용이 쉽다.

레퍼런스

레퍼런스

- Installing TensorFlow on Ubuntu

- Docker data save

- 도커 간단한 이미지 개발 및 빌드 방법

- 도커 GPU 버전 설치하기

- Docker Nginx server build

- 도커로 우분투, 아파치, PHP 이미지 만들기

- 도커로 Nginx, Node 서버 빌드 및 배포

- NVIDIA GPU docker usage

- NVIDIA GPU docker usage, 2019

- Kubernetes Tutorial for Beginners: Basic Concepts (spacelift.io)

- Understanding Docker Layers for Efficient Image Building

_logo.svg/375px-Docker_(container_engine)_logo.svg.png)